En los últimos años es innegable la irrupción de Inteligencia Artificial en nuestras vidas, trascendiendo más allá del ámbito académico e investigador de sus orígenes. Somos testigos, cada vez con mayor frecuencia, de los éxitos y casos de uso de la provisión de inteligencia, capacidad de aprendizaje, razonamiento y autonomía en los sistemas y procesos existentes en sectores de actividad de muy diversa índole.

La progresiva mayor madurez digital de los ecosistemas industriales, y el desarrollo de nuevas tecnologías de ingesta y consumo de grandes cantidades de datos (Big Data), han permitido que los modelos de Inteligencia Artificial dispongan de un sustrato de información de una riqueza y diversidad sin precedentes.

Es precisamente este ecosistema digital la principal clave para que los modelos de Inteligencia Artificial puedan observar el entorno donde están desplegados, y aprender de ellos para poder entenderlo (descripción), predecir tendencias (predicción) y/o tomar decisiones óptimas enlos procesos y operaciones existentes en dicho entorno. Este magnífico ámbito de oportunidad para la Inteligencia Artificial ha sido aprovechado por grandes compañías locales y multinacionales, que han asimilado esta tecnología como una competencia clave para sus procesos de negocio. Así, la popularidad del término Inteligencia Artificial, en todas sus vertientes, ha ido más allá del circuito empresarial para llegar hasta el usuario que consume productos y servicios con funcionalidades basadas en esta tecnología.

Podemos entender la Inteligencia Artificial desde la concepción de la evolución del aprendizaje humano. Pensemos en el desarrollo humano:

- Un bebé captura datos por mera observación, tratando de comprender todo lo que acontece a su alrededor ("si andas, te desplazas").

- Años después aprender a realizar una operación imitando el patrón estímulo-respuesta que observa ("si hay piedras, te puedes caer").

- Finalmente, termina tomando sus propias decisiones ("voy a correr despacio, porque hay piedras y he aprendido que me puedo caer con mayor probabilidad").

En esencia, estamos hablando de las etapas de modelización descriptiva, predictiva y prescriptiva en Inteligencia Artificial. La diferencia es que, en este segundo caso, el ser humano se convierte en un algoritmo de aprendizaje que, una vez entrenado para hacer su tarea, se convierte en un modelo computacional que puede desempeñar dicha tarea de manera autónoma y eficiente. Que sabe andar por si solo, en cualquier terreno.

Explicabilidad: ¿Qué es?

Siguiendo con este simil humano-máquina, en los últimos tiempos ha habido una creciente preocupación por comprender y explicar cómo los modelos de Inteligencia Artificial toman decisiones a partir de los datos capturados en su entorno de aplicación, particularmente en aquellos donde dichas decisiones tienen implicaciones para el ser humano (e.g. diagnóstico médico). Subyacen varios motivos para esta creciente preocupación.

Quizá la más reconocida es la naturaleza de ciertos modelos de Inteligencia Artificial (entre los cuales destacan los modelos de computación neuronal profunda, también llamados Deep Learning), cuya estructura interna y algoritmo de aprendizaje producen un modelo neuronal de dificil comprensión por un humano no docto en el campo de la Inteligencia Artificial.

Del mismo modo que un adolescente toma decisiones sin dar explicaciones del porqué, no podemos esperar que los modelos Deep Learning ciertamente, los adolescentes de la Inteligencia Artificial, expliquen lo que han aprendido a hacer sin más que exponer su estructura interna.

Es necesario proporcionar herramientas que muestren en qué datos se fijan los modelos para producir su salida, estimar los límites de rendimiento del modelo (e.g. bajo qué estímulo la decisión del modelo cambia de sentido), o simplificar los modelos hasta un punto comprensible por la audiencia que demanda la explicación de sus salidas. En definitiva, un psicólogo que diseccione la mente del adolescente y ayude a que sus padres entiendan por qué se comporta como lo hace.

La necesidad de explicar los modelos de Inteligencia Artificial es, sin duda, uno de los campos de investigación más vanguardistas del último lustro, acuñando lo que hoy día se conoce como XAI (Explainable Artificial Intelligence). Este campo de estudio comprende técnicas y métodos orientados a la explicación de la Inteligencia Artificial, teniendo en cuenta tres factores fundamentales:

- La naturaleza del modelo a explicar, que puede hacerlo desde inherentemente transparente (un árbol de decisión) hasta completamente opaco e ininteligible (un modelo de aprendizaje profundo).

- La audiencia objetivo por la que se persigue la explicación del modelo, sean gerentes que pretenden valorar el rendimiento de sus activos basados en Inteligencia Artificial, desarrolladores que pretenden entender mejor los modelos para poder extender sus capacidades, o usuarios finales que estén interesados en las implicaciones que el uso de esta tecnología tiene en cuestiones sensibles como la privacidad de sus datos.

- La forma en la que dicha explicación va a ser fabricada y presentada a la audiencia, que dependerá de su grado de conocimiento y capacidades cognitivas, así como de las posibilidades que brinde el modelo de ser explicado en una u otra forma. En definitiva, cómo presentar a los padres las conclusiones del estudio psicológico de su hijo/a adolescente, sin que se pierdan en tecnicismos y logrando que lo comprendan en su integridad.

Explicabilidad: ¿Cómo se logra?

Atendiendo a estos últimos factores, podemos establecer una categorización estructurada de las técnicas XAI existentes para explicar modelos de Inteligencia Artificial. Como ya se ha mencionado anteriormente, existen modelos transparentes y no transparentes (opacos). Sin embargo, debemos entender la transparencia de un modelo como una escala de niveles, ya que podemos focalizarla en el entendimiento del modelo ya aprendido, en la comprensibilidad y/o en la replicabilidad de su proceso de aprendizaje.

Diferentes audiencias, diferentes propósitos, diferentes necesidades de transparencia en los modelos, que en los denominados modelos transparentes son facilitados, en mayor o menor medida,

por el proceso de entrenamiento o la estructura computacional del modelo en sí.

Debido a sus características, los modelos transparentes son inherentemente entendibles por los humanos, y no necesitan de explicación. Pensemos en un árbol de decisión, fácilmente interpretable y replicable por un humano, en contraposición con una máquina de vectores soporte. Simplemente el nombre asusta a cualquiera, ¡como para querer entenderlo!

Por contra, la explicabilidad de modelos no transparentes se aborda con el uso de técnicas XAI post-hoc, capaces de lidiar con modelos cuya complejidad impide el entendimiento directo del proceso por el que toman sus decisiones. Distinguimos entre:

- técnicas post-hoc agnósticas, diseñadas para abordar cualquier tipo de modelo no transparente sin tener en cuenta su estructura interna;

- técnicas post-hoc específicas para un modelo determinado, lo que permite una profundidad mayor a la hora de analizar el modelo a costa de una menor generalidad para su utilización con modelos de diferente naturaleza.

Ilustremos cómo funcionan estas técnicas con dos ejemplos, uno agnóstico y otro específico al modelo explicado.

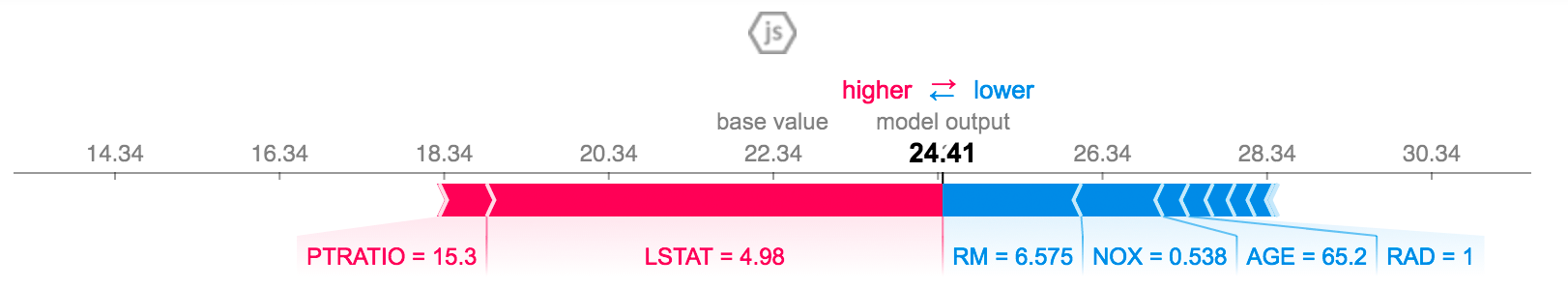

Por un lado, la librería SHAP aúna múltiples métodos para la explicacion de diversos modelos, ya sea por la vía agnóstica o por la específica. Para ello, trabaja con el modelo ya entrenado para generar varios tipos de diagramas. Centremos nuestra atención en uno de ellos, denominado diagrama de fuerzas (Force plot), ejemplificado en la Figura 1. Imaginemos que el modelo observa los valores de ciertas variables, y aprende cómo generar un valor a su salida según una serie de ejemplos representativos del problema en cuestión. Utilizando la técnica XAI conocida como LIME (Local Interpretable Model-Agnostic Explanations, el diagrama de fuerzas muestra gráficamente la intensidad con la que un cambio en una de las entradas al modelo empuja la salida hacia un sentido u otro. Así, el usuario (la audiencia) es capaz de apreciar visualmente la importancia que tiene cada una de las variables a la hora de generar una salida. Este tipo de diagramas nos permite corroborar si lo que el modelo ha aprendido es coherente con lo que el usuario podría esperar a priori, por su conocimiento experto en el dominio, teorías validadas o por pura intuición.

Figura 1: Diagrama de fuerzas (Force plot) proporcionado por SHAP para un problema genérico

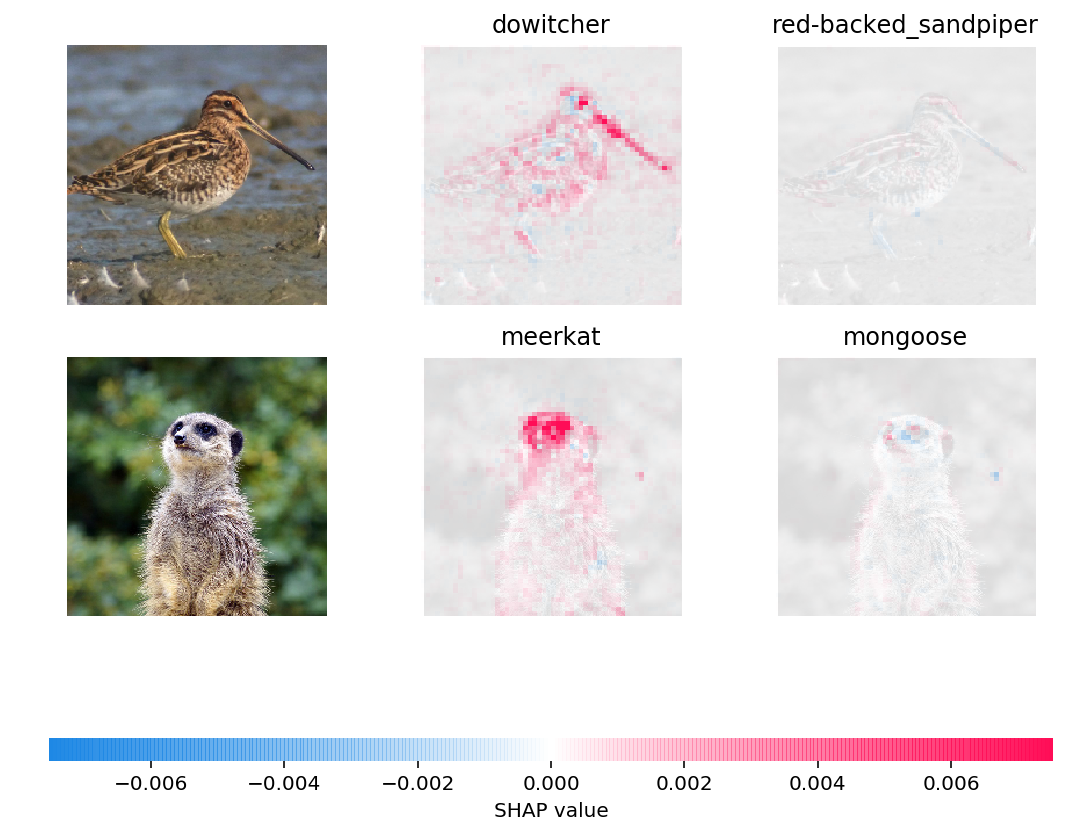

En lo que respecta a técnicas específicas, detengámonos en la Figura 2, donde se muestra el resultado de la aplicación de la técnica XAI post-hoc conocida como PRP (Pixel-wise Relevance Propagation para un modelo de aprendizaje profundo capaz de determinar si una foto alimentada a su entrada se corresponde con diferentes especies de animales. Para ello, el modelo aprende a partir de fotos de especies ya anotadas con el animal que en ellas aparecen. En esta tarea de aprendizaje, un modelo que únicamente proporcione una salida del tipo e.g. especie de pájaro X al 90 % de seguridad, no desvela qué ha visto el modelo en la foto para hacer dicha estimación. En cambio, una técnica como PRP puede proporcionar un mapa de calor que indique las regiones de la imagen donde el modelo se está fijando para producir su salida y, a su vez, aportar confianza a las predicciones que el software genera. Como se muestra en la figura, el modelo ha aprendido a fijarse en el pico para determinar el tipo de ave. Si un ornitólogo tuviese que confiar en un modelo de aprendizaje profundo, este mapa de calor sería de sumo valor para validar lo aprendido por el modelo de acuerdo a su conocimiento experto, y podría dar nuevas perspectivas al usuario sobre las peculiaridades de las especies animales bajo estudio.

Perspectivas hacia el Futuro de XAI

La relativa infancia de XAI en el panorama de la investigación sobre la Inteligencia Artificial motiva la incesante aparición de nuevas técnicas XAI en la literatura. Pese a esta actividad vertiginosa, aún quedan muchos retos por solventar, todos ellos recogidos en nuestro reciente resumen sobre esta temática.

En este análisis crítico de la literatura actual sobre XAI debatimos junto con colaboradores del Joint Research Lab on Artificial Intelligence los conceptos, taxonomías, avances y perspectivas sobre el campo. Rescatamos de él tres de los retos mas relevantes, invitándoos a leer nuestro estudio para más detalles:

- Existe una dicotomía reconocida entre el rendimiento del modelo (e.g. su eficacia y desempeño a la hora de realizar la tarea encomendada) y su explicabilidad, pero a menudo es definida incorrectamente. Es cierto que existe un compromiso entre rendimiento y explicabilidad en las situaciones en las que los datos son muy abundantes y presentan mucha variabilidad/diversidad. En estos casos, la elevada complejidad del modelo necesaria para que este aprenda dichos datos con suficiente precisión compromete su explicabilidad, como es el caso de los modelos de aprendizaje profundo. Por el contrario, la utilización de modelos transparentes, en general, arrojarán un peor desempeño, pero serían más fácilmente explicables. En esta balanza identificada entre rendimiento y explicabilidad, es necesario ajustar los parámetros del modelo según los requisitos del caso de uso (¿qué quiere el médico? Un diagnóstico certero del modelo, o que él mismo sea capaz de validar lo que ha aprendido el modelo de acuerdo a su conocimiento experto? ). Para ello, se necesitan definir metodologías para evaluar cuantitativamente cómo de explicable es un modelo respecto a otro. Desafortunadamente, esta intersección entre las ciencias cognitivas y el aprendizaje máquina aún resiste como uno de los pocos territorios inexplorados en la Inteligencia Artificial.

- Idealmente, las técnicas XAI deben servir para un propósito lícito: entender el funcionamiento de un modelo de Inteligencia Artificial, explicar el conocimiento que este ha aprendido, y ser capaz de razonar sobre él. Sorprendentemente, las técnicas XAI pueden ser empleadas para otros objetivos no lícitos, como el comprometer la privacidad de los datos con los que el modelo fue entrenado, o quebrantar la propiedad intelectual (el valor de negocio) que reside implícito en la estructura del modelo en sí. Además, la disección del modelo mediante técnicas XAI puede dar conocimiento a un agente malicioso en el sistema que quiera confundir al modelo (por ejemplo, en sistemas de reconocimiento biométrico para infraestructuras críticas). Sin duda alguna, el nicho de oportunidad que brinda XAI en el futuro próximo debe ser abordado desde ambas aproximaciones (usos lícitos y no lícitos), para que, rescatando el simil humano, los adolescentes no aprendan a engañar al psicólogo y, eventualmente, hagan que los padres premien sus malas acciones.

- Durante años, diversos organismos y compañías han creado guías metodológicas para un uso responsable de los modelos de Inteligencia Artificial en sus operaciones y procesos. Dentro de estas directrices nos encontramos con valores como:

Discriminación: la utilización de un modelo de Inteligencia Artificial no puede generar discriminación que afecte a individuos ni colectivos en temas como etnia, religión, orientación sexual, diversidad funcional, origen o cualquier otra condición personal.

Distinción: la interacción entre un humano y un modelo de Inteligencia Artificial debe ser reconocible. Un humano debe saber cuando interactúa con una Inteligencia Artificial, y cuándo no.

Inteligencia Artificial y regulación/estrategia: el desarrollo de productos y servicios de Inteligencia Artificial debe estar alineado con los objetivos de las Naciones Unidas para el desarrollo sostenible.

Privacidad: los modelos de Inteligencia Artificial, en particular aquellos basados en datos, deben cumplir las políticas y restricciones de privacidad durante todo su ciclo de vida.

XAI está llamado a jugar un papel trascendental para asegurar que los modelos de Inteligencia Artificial cumplen con todos estos valores. Por ejemplo, podemos explicar el sesgo de un modelo respecto a sus datos de entrada explicando su estructura ya aprendida, lo que permitiría identificar situaciones en las que el modelo está mirando características sensibles en lo que respecta a equidad y discriminación.

XAI puede contribuir, además, a la trazabilidad de las decisiones producidas por el modelo, desvelando las razones por las que se produjeron decisiones inesperadas de los modelos de Inteligencia Artificial. La utilidad de XAI en el contexto de la Inteligencia Artificial responsable es múltiple, y sería sin duda un driver clave en el despliegue masivo de modelos que se prevé inminente en casi todos los sectores de actividad.

XAI: Y ahora ¿qué?

La implementabilidad de los modelos de Inteligencia Artificial no es solo una cuestión de ganar centésimas de precisión mediante el diseño de modelos cada vez más complejos de entender. Nuestra experiencia nos dice que aspectos como la trazabilidad, la equidad de las decisiones o la simple comprensión del modelo son mucho más importantes para que la Inteligencia Artificial sea de utilidad práctica.

Debemos ser responsables en la adopción de esta tecnología, para evitar que las expectativas depositadas en ella no caigan "en saco roto" por no tener en cuenta dichos aspectos.

- Entendamos la Inteligencia Artificial como un proceso transformador, una nueva revolución tecnológica, que debe aterrizar en nuestras vidas acomodándose a principios y valores humanos inquebrantables que han impulsado la prosperidad de la sociedad humana moderna desde sus orígenes.

- Entendamos bien al adolescente.

* Este artículo ha sido escrito en colaboración con Alejandro Barredo Arrieta y Sergio Gil-López.